Компания Alibaba Group представила революционную архитектуру QwenLong-L1, которая позволяет большим языковым моделям эффективно обрабатывать чрезвычайно длинные документы. Новая технология открывает возможности для анализа корпоративных отчётов, финансовых ведомостей и юридических контрактов любого размера.

G. Ostrov

Alibaba Group представила QwenLong-L1 — революционную архитектуру, которая решает одну из главных проблем современных языковых моделей: неспособность эффективно работать с длинными текстами. Это достижение может кардинально изменить подход к анализу больших документов в корпоративной среде.

Проблема длинных контекстов

До недавнего времени большие модели с рассуждениями (LRM) сталкивались с серьёзными ограничениями при работе с длинными текстами. Хотя обучение с подкреплением значительно улучшило их навыки решения задач, эффективность моделей резко снижалась при обработке текстов свыше 4000 токенов.

Это ограничение препятствовало практическому применению LRM в областях, требующих работы с обширными базами знаний — научных исследованиях, юриспруденции, финансовом анализе и корпоративном документообороте.

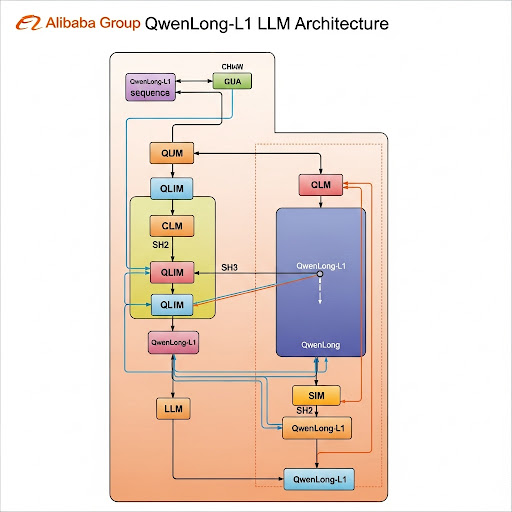

Инновационный подход QwenLong-L1

Ключевое преимущество QwenLong-L1 заключается в многоэтапном подходе к обучению, который включает три основные стадии:

1. Контролируемая тонкая настройка (SFT)

На первом этапе модель обучается на примерах рассуждений с длинными контекстами, что создаёт основу для точного извлечения информации из больших объёмов данных.

2. Поэтапное обучение с подкреплением

На втором этапе длина входных документов постепенно увеличивается, обеспечивая стабильную адаптацию модели к более сложным задачам. Этот подход позволяет избежать резкого падения производительности.

3. Выборка сложных примеров

Заключительный этап использует самые трудные примеры из предыдущих стадий, стимулируя модель к освоению наиболее сложных задач и исследованию различных путей рассуждения.

Гибридная система вознаграждения

QwenLong-L1 использует инновационную гибридную систему вознаграждения, которая сочетает:

- Строгую проверку на основе правил для гарантии точности

- Оценку другой LLM, сравнивающую смысловое содержание ответов

Такой подход позволяет более гибко обрабатывать различные варианты правильных ответов, характерные для длинных и сложных документов.

Впечатляющие результаты тестирования

Тестирование QwenLong-L1 на семи эталонных наборах данных для задач вопрос-ответ показало выдающиеся результаты:

- QwenLong-L1-32B — производительность, сопоставимая с Anthropic's Claude-3.7 Sonnet Thinking, превосходит OpenAI o3-mini и Qwen3-235B-A22B

- QwenLong-L1-14B — превзошла Google Gemini 2.0 Flash Thinking и Qwen3-32B

Специализированные навыки

Обучение с помощью QwenLong-L1 привело к развитию у модели специализированных навыков работы с длинными контекстами:

- Лучшее «заземление» ответов — связывание с конкретными частями документа

- Постановка промежуточных целей

- Отслеживание и исправление ошибок

- Верификация ответов

Открытый доступ и применение

Alibaba выпустила код QwenLong-L1 и веса обученных моделей в открытый доступ, что открывает широкие возможности для применения в различных областях:

- Юридическая сфера — анализ контрактов и законодательства

- Финансы — обработка отчётности и аналитических материалов

- Корпоративный сектор — работа с внутренней документацией

- Научные исследования — анализ больших массивов данных

Это достижение Alibaba может стать поворотным моментом в развитии искусственного интеллекта, делая анализ длинных документов доступным и эффективным для широкого круга задач.

Более подробную информацию можно найти на официальном сайте Alibaba Group.

В случае каких-либо проблем напишите нам, мы поможем быстро и качественно!